결론: UALink와 오픈AI가 만든 파괴적 변화, 그리고 Cisco의 도약

오픈AI의 전략적 투자 확대와 UALink 컨소시엄의 시장 영향력 증대는 Cisco의 데이터센터 사업 부문에 장기적 성장 모멘텀을 제공한다.- 오픈AI가 ‘공익기업(PBC)‘으로 전환하고 약 $1.4조 규모의 대규모 인프라 투자를 발표하면서 AI 워크로드가 폭발적으로 증가하고 있다.

- AI 인프라의 진화에 '개방형 연결 표준'인 UALink가 대세로 자리잡으며, 네트워크 인프라의 유연성과 확장성이 최우선 가치로 부상한다.

- 핵심 연결 및 보안, 최적화된 네트워크 아키텍처가 불가결해지면서, 시스코(Cisco)는 경쟁 및 파트너십 양면에서 수혜가 기대된다.

배경: 오픈AI, UALink, 그리고 시장 환경의 변화

1. 오픈AI의 PBC 전환과 $1.4조 인프라 투자 계획

2025년 10월, 오픈AI는 기존 비영리 모체에서 ‘공익·영리 병행’ PBC(Public Benefit Corporation)로 전환하며, 신규 투자 유치와 데이터센터 확장에 본격 나섰다. CEO 샘 알트만은 약 $1.4조 규모의 대규모 인프라 투자 계획을 공개했으며, 이는 약 30기가와트(GW)의 데이터센터 용량에 해당한다. 이는 미국 가정 약 750만 가구를 공급할 수 있는 규모로, 단순한 소프트웨어 회사를 넘어 'AI 인프라 유틸리티'로의 진화를 의미한다.

오픈AI의 계획에 따르면 장기적으로는 주당 1기가와트씩 추가할 수 있는 기술 및 재무적 체계 구축을 목표로 하고 있으며, 이를 위해 AMD, Broadcom, NVIDIA, Oracle 등과의 전략적 파트너십을 강화하고 있다. 이러한 규모의 인프라 확충은 전 산업 밸류체인에 걸쳐 네트워크, 스위칭, 라우팅, 스토리지 장비 수요를 급증시키고 있다.

2. UALink 컨소시엄과 AI 인프라 혁신

엔비디아 독점의 NVLink에 대응하는 UALink 컨소시엄(AMD, Broadcom, Cisco, Google, HPE, Intel, Meta, Microsoft 등 포함)이 빠른 속도로 개방형 AI 상호연결 표준을 확립했다. 2025년 4월 공식 출범한 UALink 1.0 표준은 다음과 같은 혁신적 특징을 제공한다:

- lane당 200Gbps 처리량 (4중 lane 시 양방향 800Gbps)

- 왕복 지연시간 1마이크로초 미만 (100~150나노초 포트 간 지연)

- 단일 패브릭에서 최대 1,024개 가속기 연결 지원

- 표준 Ethernet SerDes 기반으로 상호운용성 극대화

이는 다양한 하드웨어, 소프트웨어 벤더가 데이터센터 인프라에 자유롭게 참여할 수 있게 하며, 신생 AI 기업들도 인프라를 비용 효율적으로 확장할 수 있게 하는 진정한 '개방형 생태계'를 창출했다.

Cisco의 전략적 포지셔닝과 성장 포인트

1. 폭발적 AI 인프라 수요 확보 - 실적으로 증명된 성과

Cisco는 이미 실제 수익 성과로 AI 인프라 시장 주도권을 증명했다.2025 회계연도 AI 인프라 주문 현황

- FY 2025 총 AI 인프라 주문: $2.0+ 억 달러 (초기 목표 $1.0억 달러의 2배 이상)

- Q4 FY 2025 단계: $800M 주문 (Q3의 $600M에서 증가)

- 주문 구성: 약 2/3이 시스템, 1/3이 광학(Optics)

이는 단순한 수익이 아니라 webscale 고객 5개사가 Cisco의 제품을 채택하고 있으며, 상위 6개 webscaler 중 3개가 3자리 성장률을 기록했다는 의미이다. 이 정도 규모는 NVIDIA가 3개월(Q4 FY 2025)에 약 50억 달러의 AI 네트워킹 매출을 기록하는 것과 비교하면, Cisco가 차기 5년간 50~100배 성장의 베이스를 갖춘 초기 단계이다.

2026 재정연도 성장 전망

- FY 2026 매출 전망: $59.0~$60.0억 달러 (전년 대비 +5%)

- AI 인프라 사업 비중 확대: 이미 $1.0억 달러 이상이 인식 수익으로 변환

- 첫 분기(Q1 FY 2026) 매출 예상: $14.65~$14.85억 달러

Cisco의 신중한 가이던스에도 불구하고, AI 인프라 주문 탄성(elasticity)은 여전히 공급 제약, 수요 제약이 아닌 상황이다. 즉, Cisco가 충분한 Silicon One 칩과 스위칭 용량을 공급할 수 있다면 수요는 훨씬 높을 가능성이 있다.

2. RoCEv2를 통한 AI 클러스터 최적화 - 고성능 저지연 통신의 핵심

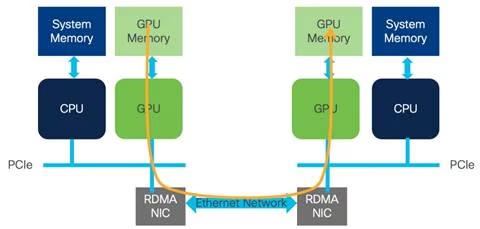

AI 데이터센터에서 GPU 간 고속 통신은 모델 학습 성능을 결정하는 중요한 요소이다. Cisco는 RoCEv2 (RDMA over Converged Ethernet v2) 기술을 통해 이 문제를 해결하고 있다.

RDMA 기술의 중요성

RDMA(Remote Direct Memory Access)는 고성능 컴퓨팅(HPC) 및 스토리지 네트워킹에서 오랫동안 사용되어온 검증된 기술이다. RDMA의 핵심 장점은 다음과 같다:

- 직접 메모리 접근: CPU를 거치지 않고 GPU 메모리 간 직접 데이터 전송

- 초저지연(Ultra-Low Latency): 운영체제 네트워크 스택 우회로 마이크로초 단위 지연 달성

- 높은 처리량(High Throughput): 네트워크 어댑터 하드웨어에서 오프로드된 전송으로 최대 효율성 구현

- CPU 오버헤드 감소: CPU 사용률을 최소화하여 AI 모델 학습에 집중 가능

- 전력 효율성: CPU 부하 감소로 인한 에너지 절감

RoCEv2의 등장과 표준화

초기 RDMA 구현은 InfiniBand (IB)를 중심으로 발전했다. InfiniBand는 고성능 컴퓨팅 환경에 이상적이었으나, 엔터프라이즈 데이터센터에서는 별도의 네트워크 인프라 구축 비용이 대가였다.

이 문제를 해결한 것이 RoCEv2 (RDMA over Converged Ethernet v2)이다:

RoCE 진화 과정

- RoCE v1 (2010년): Layer 2 동일 네트워크 내에서만 작동

- RoCEv2 (2014년): IP 라우팅 기반 지원, 광범위한 네트워크 확대 가능

RoCEv2는 InfiniBand 전송 프로토콜을 Ethernet, IP, UDP 헤더로 캡슐화하여, 기존 Ethernet 네트워크 인프라 위에서 RDMA의 모든 장점을 활용할 수 있게 한다. 이는 엔터프라이즈 데이터센터에서 별도의 네트워크 구축 없이도 고성능 AI 인프라를 구현할 수 있다는 의미이다.

RoCEv2의 기술적 요구사항

RoCEv2가 최적의 성능을 발휘하려면 다음 조건을 만족해야 한다:

무손실 네트워크(Lossless Fabric)- ECN (Explicit Congestion Notification): 네트워크 혼잡을 사전에 감지하여 송신자에게 알림

- PFC (Priority Flow Control): 우선순위 기반 혼잡 제어로 중요 트래픽 보호

Cisco의 솔루션

- Silicon One 칩에 내장된 PFC, ECN 기술

- Nexus 시리즈 스위치의 통합 큐잉 및 혼잡 관리

- AI 워크로드에 최적화된 QoS(Quality of Service) 프로필

AI 클러스터에서의 GPUDirect RDMA 활용

GPUDirect RDMA는 NVIDIA GPU 간 RoCEv2를 통한 메모리 직접 통신을 의미한다. 이를 통해:

- 분산 학습(Distributed Training) 성능 향상: 여러 GPU 간 그래디언트 동기화 지연 최소화

- 집합통신(AllReduce) 최적화: 대규모 모델 학습에서 병목 현상 제거

- 확장성(Scalability) 극대화: 수백~수천 개 GPU 클러스터의 효율적 관리

실제로 Meta, Google 등 대형 AI 회사들은 RoCEv2 기반 데이터센터 네트워킹을 표준으로 채택하고 있으며, Cisco가 이들의 주요 공급자이다.

3. Silicon One G200/G202 - AI 최적화 네트워킹 칩의 경쟁 우위

Cisco의 Silicon One G200/G202 ASIC은 AI 워크로드 최적화 설계로, 다음과 같은 기술적 장점을 제공한다:

핵심 성능 지표

- 처리량: 51.2 Tbps (이전 세대 대비 대폭 향상)

- 32K 400G GPU 클러스터를 2계층 네트워크로 구성 가능

- 스위치 40% 감소, 광학 50% 감소, 네트워크 계층 33% 감소

AI/ML 작업 최적화

- 작업 완료 시간(Job Completion Time) 1.57배 단축 (Enhanced Ethernet 활용)

- 극저지연 + 고성능 로드 밸런싱: AI 분산 학습 작업의 동기화 시간 최소화

- 집합통신(AllReduce) 최적화: 대규모 모델 학습에서 병목 현상 제거

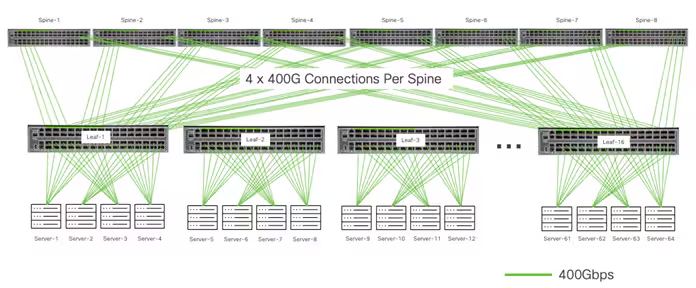

Cisco 백엔드 네트워크 아키텍처

위 아키텍처는 Cisco의 대규모 AI 클러스터 설계 원칙을 보여준다:

계층 구조

- Spine 계층: 8개의 400Gbps 포트 스위치로 전체 클러스터 상호 연결

- Leaf 계층: 각 Leaf당 4개의 400G 포트로 Spine 연결 (Oversubscription 제거)

- Server 계층: 4개의 400G 포트로 GPU 서버 연결

이 구조의 장점

- Non-blocking Fabric: 모든 서버 간 Full Bandwidth 통신 가능

- 예측 가능한 성능(Deterministic Performance): 모든 GPU가 동일한 네트워크 성능 보장

- 선형 확장성: 클러스터 크기 증가 시에도 성능 저하 없음

이러한 아키텍처는 Meta, Google, AWS 등 주요 webscaler가 이미 대규모 배포 중이며, 용량 제약으로 인한 공급 부족이 Cisco의 가장 큰 “좋은 문제"가 되었다.

4. NVIDIA와의 전략적 파트너십: Secure AI Factory

2025년 3월 Cisco와 NVIDIA는 Cisco Secure AI Factory with NVIDIA를 발표했으며, 이는 단순한 기술 협력을 넘어 엔터프라이즈 AI 시장의 표준 아키텍처로 자리잡고 있다.

주요 협력 영역

- NVIDIA Spectrum-X Ethernet 통합: Cisco의 Nexus 스위치와 NVIDIA GPU의 저지연 고속 연결

- Secure AI Factory 검증 레퍼런스 아키텍처: 규제 및 보안을 고려한 기업용 AI 인프라 표준

- 통합 보안: Cisco Hypershield + Cisco AI Defense로 AI 워크로드 전체 계층 보호

2025년 10월 발표 - N9100 데이터센터 스위치

- NVIDIA Spectrum-X 기반 첫 번째 파트너 개발 스위치

- Neocloud 및 Sovereign Cloud 배포용 NVIDIA Cloud Partner 준수 아키텍처

이 협력은 Broadcom, NVIDIA 같은 기존 경쟁자들과의 차별화를 만들며, 엔터프라이즈 고객들이 신뢰할 수 있는 폐쇄된 보안 환경과 개방형 표준의 균형을 제공한다.

5. UALink 및 개방형 AI 생태계로부터의 직접 수혜

UALink 등장으로 데이터센터 내 가속기, 스토리지, 네트워크 간 '개방형 고성능 연결'이 시장 표준화되는 추세가 가속화되고 있다. Cisco는 UALink 컨소시엄의 창립 멤버로서 다음과 같은 이점을 얻는다:

직접적 수혜

- AI 스위치/라우터/인터커넥트 시장 확장: 다중 하드웨어 환경에서 상호운용성 리더십 강화

- 장기적 AI 규모·복잡도 증가에 따른 표준 기반 다중 벤더 지원 확대

- Sovereign Cloud 시장 진입장벽 하락: 중동, 동남아 등 개발도상국의 자체 AI 인프라 구축 촉진 → Cisco 네트워크 솔루션 수요 급증

간접적 수혜

- WebScale 고객들의 공급 다변화 추구: NVIDIA 의존도 감소로 Cisco 채택 시급성 높아짐

- 신생 AI 스타트업 및 중소 데이터센터 사업자들의 인프라 진입 장벽 하락: Cisco 네트워킹 지원 범위 확대

6. 중동 Sovereign AI 인프라 - 지정학적 성장 엔진

Cisco는 오픈AI 투자와 동시에 중동의 Sovereign Cloud 시장을 선제적으로 확보하고 있다.

주요 프로젝트

Saudi Arabia - HUMAIN Partnership (2025년 5월)

- 리야드, 제다 지역 Sovereign Cloud 데이터센터 구축

- Silicon One 기반 AI 패브릭: 비차단형(non-blocking) 아키텍처로 1PB/s 대역폭 지원

- 국가 데이터 보호: 해외 데이터 이동 없이 국내 데이터셋 학습 가능

- 사우디 비전 2030 연계: 50만명의 AI 인재 양성 목표 지원

UAE - G42 Partnership (2025년 10월)

- 대규모 AI 클러스터 구축: AMD의 MI350X GPU 기반

- Regulated Technology Environment (RTE) 통합: 규정 준수, 보안, 투명성 보장

- 미-UAE AI 협력 가속화: 지정학적으로 서방진영 AI 인프라 표준 강화

7. 소프트웨어/구독 기반 사업 모델 고도화 - 지속성 있는 성장

Cisco는 단순 하드웨어 회사가 아니라 소프트웨어 플랫폼 회사로의 전환을 지속 중이다.

Splunk 인수 (2024년 $28B)

- 실시간 데이터 분석 플랫폼 획득

- AI 인프라 운영 데이터의 가시성·최적화 솔루션 제공

- AI 보안 위협 탐지·대응 강화

소프트웨어·구독 매출 비중

- 총 매출의 54% 이상이 반복 수익(Recurring Revenue)

- 하드웨어 사이클 의존도 감소 → 예측 가능한 성장 모델로 전환

이 구조는 AI 하드웨어 사이클의 변동성을 상쇄하고, 장기 고객 관계 기반의 높은 수익성(High Margin) 사업으로 전환을 의미한다.

오픈AI 투자의 구체적 영향: 네트워크 인프라 수요 산정

대규모 데이터센터 구축에 따른 네트워킹 비용 구조

오픈AI의 $1.4조 인프라 투자 중 네트워킹 장비 비중은 일반적으로 다음과 같다:

데이터센터 구성 요소 비용 분배

- 컴퓨팅 (GPU/CPU): 50~60% ($700~840B)

- 전원·냉각 인프라: 15~20% ($210~280B)

- 네트워킹·스토리지: 15~20% ($210~280B)

- 시설·기타: 5~10% ($70~140B)

이 중 네트워킹 인프라 ($210~280B) 시장에서 Cisco의 점유율:

- 스위칭/라우팅: Cisco, Arista, Broadcom 3사 중심

- 광학 모듈: Cisco, NVIDIA, Broadcom 중심

- 현재 Cisco 시장점유율: 약 30~35% 추정 (기존 관계사 기반)

즉, 오픈AI 단독 프로젝트만으로도 Cisco에 $60~100B 규모의 잠재 수익 기회가 발생할 수 있다. 이는 현재 Cisco 연간 매출의 1~2배에 해당하는 규모이다.

대형 클라우드 제공자들의 AI 인프라 투자 경쟁

오픈AI의 움직임이 Microsoft, AWS, Google 등 기존 클라우드 기업들의 AI 인프라 투자 가속화를 촉발했다:

- Microsoft: OpenAI와의 재정렬을 통해 자체 데이터센터 확충 가속화

- AWS: 자체 칩(Trainium, Inferentia) 기반 AI 인프라 확대

- Google: TPU 클러스터 대규모 확충 추진

총 3사의 2025년 자본지출(CapEx) 예상: 약 $80~90B (전년 대비 +50~60%)

이는 전체 데이터센터 네트워킹 인프라 시장 규모를 연 50~70% 증가시킬 수 있으며, Cisco 같은 공급자에게 구조적 강풍(Tailwinds)을 제공한다.

성장 시나리오와 주가 잠재력

시나리오 1: 보수적 시나리오 - 현 수준 유지 + 10% 시장점유율 확대

가정

- FY 2026~2028 AI 인프라 수익 연평균 40% 성장

- 전체 매출 성장률 5~7%

- 운영이익률 22~25% 유지

결과

- 2028년 매출: $68~72B

- 2028년 EPS: $2.95~$3.20

- 목표 주가 (PER 30배): $88.50~$96

평가: 보수적이나 현 매출 성장 추이 대비 합리적이다.

시나리오 2: 기본 시나리오 - UALink 표준 확산 + 중동 Sovereign 시장 성공

가정

- FY 2026~2028 AI 인프라 수익 연평균 60% 성장

- 전체 매출 성장률 8~10%

- 운영이익률 23~26% 달성 (Splunk 통합 완성)

- 중동 Sovereign Cloud 시장에서 시장점유율 40%+ 확보

결과

- 2028년 매출: $80~88B (+40~55%)

- 2028년 EPS: $3.60~$4.15

- 목표 주가 (PER 35배): $126~$145

평가: AI 인프라 시장 성장과 Cisco의 경쟁력을 반영한 합리적 시나리오이다.

시나리오 3: 공격적 시나리오 - OpenAI 등과의 심화된 협력 + UALink 시장 지배

가정

- FY 2026~2028 AI 인프라 수익 연평균 100% 성장

- 전체 매출 성장률 12~15%

- 운영이익률 25~28%

- Cisco가 OpenAI, G42 등 주요 프로젝트의 “필수 인프라 파트너"로 자리잡음

- AI 인프라 수익이 전체 매출의 15~20% 차지

결과

- 2028년 매출: $95~105B (+70~85%)

- 2028년 EPS: $4.60~$5.40

- 목표 주가 (PER 40배): $184~$216

평가: 높은 성장이나 오픈AI, 중동 주도 프로젝트의 가시성 증가 시 가능한 시나리오이다.

위험 요인 및 고려사항

1. 경쟁 심화

- Broadcom, NVIDIA: AI 네트워킹 시장 중심 이동으로 기존 경쟁자 강화

- 새로운 진입자: Marvell, Juniper 등 AI 전문 칩 개발 진행 중

2. 기술 표준화 지연

- UALink 채택 속도: 현재 계획대로 진행되지 않을 수 있음

- NVIDIA Spectrum-X와의 공존: InfiniBand 중심 클라우드 vs. Ethernet 기반 선택의 딜레마

3. 공급망 제약

- Silicon One 칩 공급 부족: TSMC 용량 제약 시 Cisco의 수익 성장 제약 가능성

- 광학 모듈, 포트 공급: 수요 급증 시 공급 병목 가능성

4. 지정학적 리스크

- 중동 프로젝트 정치 리스크: 중동 정세 악화 시 Sovereign Cloud 투자 지연

- 미-중 기술 규제: 중국 시장 제외로 인한 잠재 시장 축소

결론: Cisco의 AI 인프라 성장 가능성 평가

Cisco는 단순히 AI 인프라 호황의 수혜자를 넘어, 차세대 AI 데이터센터 표준의 구축자로 자리잡고 있다.

핵심 성공 요인

- 기술 리더십: Silicon One의 성능 + RoCEv2를 통한 GPU 직접 통신 최적화 + NVIDIA 협력을 통한 보안/개방성 통합

- 시장 타이밍: UALink 표준 확산 시점과 OpenAI 대규모 투자 시점의 동조

- 지정학적 이점: 중동 Sovereign Cloud 시장의 선제적 확보

- 사업 모델 진화: 소프트웨어/구독 기반으로의 전환으로 수익성 강화

2028년 목표 주가

- 보수적: $88~$96

- 기본: $126~$145

- 공격적: $184~$216

현재 Cisco 주가 대비 3년 연간 수익률 10~25% 추정

결론: Cisco는 AMD, NVIDIA와는 다른 각도에서 AI 인프라 붐의 지속적 수혜자로 주목할 가치가 있으며, 특히 중장기(3~5년) 포트폴리오에 AI 인프라 노출을 원하는 투자자에게 균형잡힌 선택지이다. RoCEv2 기술의 표준화와 Sovereign Cloud 시장의 성장은 Cisco의 장기적 경쟁력을 더욱 강화할 것으로 예상된다.

참고

-

“OpenAI Wants to Get to $1 Trillion a Year in Infrastructure Spend” - Axios (2025년 10월 28일)

https://www.axios.com/2025/10/28/openai-1-trillion-altman -

“Cisco Reports Fourth Quarter and Fiscal Year 2025 Earnings” - Cisco Investor Relations (2025년 8월 13일)

https://investor.cisco.com/news/news-details/2025/CISCO-REPORTS-FOURTH-QUARTER-AND-FISCAL-YEAR-2025-EARNINGS/ -

“Cisco Q4 FY 2025 Delivers Solid Growth With AI and Networking Tailwinds” - Futurum Group (2025년 8월 15일)

https://futurumgroup.com/insights/cisco-q4-fy-2025-delivers-solid-growth-with-ai-and-networking-tailwinds/ -

“Cisco and G42 Deepen US-UAE Technology Partnership to Build Secure End-to-End AI Infrastructure in the UAE” - PR Newswire (2025년 10월 28일)

https://www.prnewswire.com/news-releases/cisco-and-g42-deepen-us-uae-technology-partnership-to-build-secure-end-to-end-ai-infrastructure-in-the-uae-302596515.html -

“UALink Consortium Reshapes AI Infrastructure Economics with Open Standard Initiative” - Insights from Analytics (2025년 6월 4일)

https://www.insightsfromanalytics.com/post/ualink-consortium-reshapes-ai-infrastructure-economics-with-open-standard-initiative

면책 사항: 이 글은 투자 조언이 아닌 일반적인 정보 제공을 목적으로 작성되었습니다. 모든 투자 결정의 책임은 투자자 본인에게 있으며, 작성자는 이로 인한 직·간접적인 손실에 대해 어떠한 책임도 지지 않습니다.